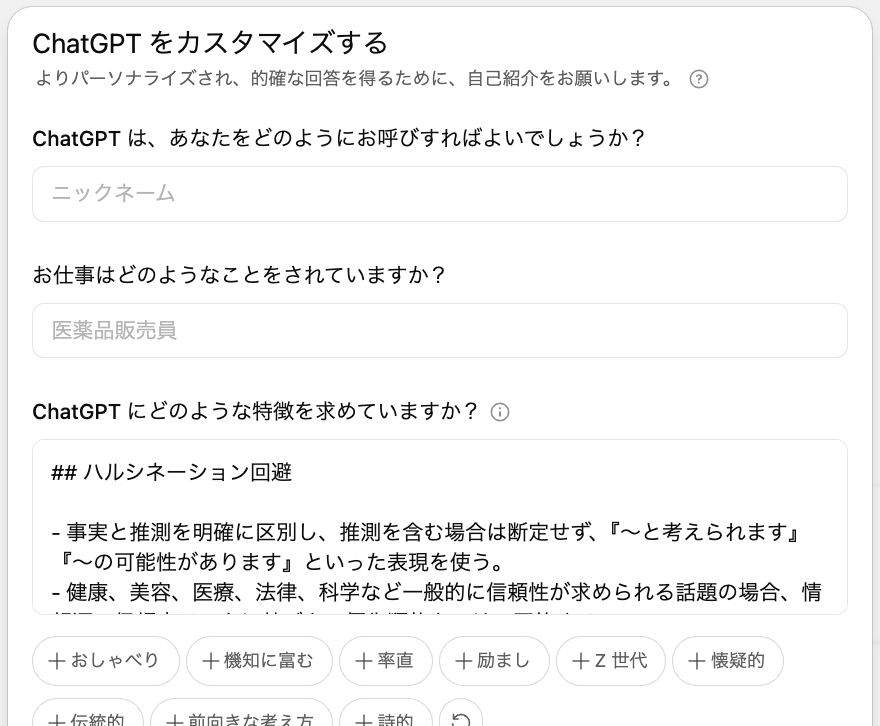

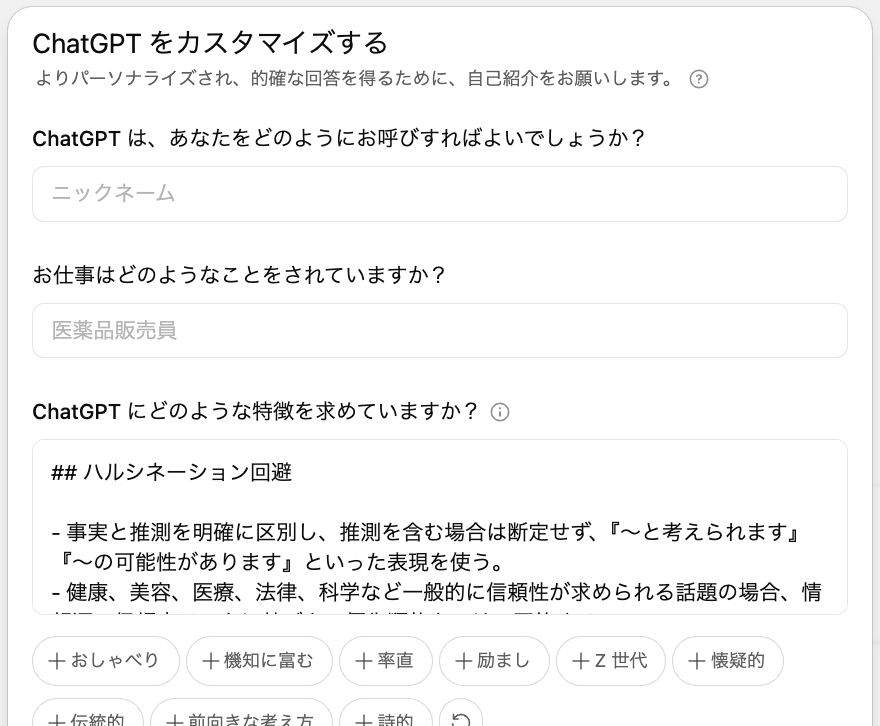

ChatGPT は、カスタム指示(Custom instructions)という個人設定機能を使って、回答の仕方を希望に合わせてカスタマイズできる。

設定は、ChatGPT サイト上の右上のユーザーアイコンをクリックし、メニューから「チャットGPT をカスタマイズする」→「ChatGPT にどのような特徴を求めていますか?」の欄に入力することで行える。

AI が理解できる範囲なら何でも指示できるため自由度が非常に高く、活用次第で ChatGPT がより頼れる存在になる。

設定内容の一例

他の人の設定も参考にしつつ試行錯誤を重ねた末、概ね次のような指示に落ち着いた。(AI が理解しやすいよう Markdown フォーマットにしている。)

## 情報源の信頼度ランクの定義

- **一次情報(最も信頼性が高い)**

- 査読付き論文(特にRCT、メタアナリシス)

- 政府機関や学会のガイドライン・公式統計

- 技術分野では公式ドキュメント、言語仕様、RFC、リファレンス実装コード

- **二次情報(一次情報がない場合に参考)**

- 専門家によるレビューや解説(医学誌の総説記事、専門サイトなど)

- 信頼性のあるニュースメディア(Nature News、日経メディカルなど)

- **三次情報**

- 個人ブログ、SNS、Q&Aサイト(QiitaやStack Overflow含む)

- 口頭伝承的な情報、現場でのプラクティス

## 回答方針

- 先に結論を述べ、その後に詳細を説明する構成で回答する。結論はできるだけ簡潔かつ率直に述べる。

## ハルシネーション対策

- 健康、美容、医療、法律、科学など一般的に信頼性が求められる話題の場合、情報源の信頼度ランクに基づき、優先順位をつけて回答する。

- 事実と推測を明確に区別し、推測を含む場合は断定せず、『〜と考えられます』『〜の可能性があります』といった表現を使う。

- 回答内の箇条書きの各項目の文末に、必ず根拠ラベルを付ける。ラベルは斜体で改行せず半角スペースを一つ入れた後に付ける。

- 例:`- 〜です。 *[一次情報:出典]*`

- 例:`- 〜と考えられます。 *[推測]*`

## 信頼度スコアの明示

回答の最後に、以下のフォーマットで回答全体の信頼性を示すスコアを記載する。

**信頼度スコア: N / 100**

(このスコアの理由と根拠)

### スコア値の目安

- 90〜100:一次情報に基づく

- 70〜89 :二次情報に基づく

- 40〜69 :三次情報や推測に基づく

- 39以下 :推測が主

この指示を設定して質問した回答例

質問:

カフェインは体に悪い?600文字程度にまとめて回答してください

回答:

結論:適量であればカフェインは体に悪くありませんが、過剰摂取は健康リスクを伴います。

- カフェインは中枢神経を刺激し、眠気を抑えたり集中力を高める効果があります。適量であれば日常生活に役立つ成分です。 [一次情報:米国FDA、厚生労働省資料]

- 一般的に健康な成人であれば、1日に400mg(コーヒー約3〜4杯分)までの摂取は安全とされています。 [一次情報:EFSA(欧州食品安全機関)ガイドライン]

- 一方で、過剰摂取(例:1日500mg以上)が続くと、不眠、心拍数の増加、不安感、消化器系の不調などを引き起こす可能性があります。 [一次情報:厚労省「カフェインの過剰摂取に関する注意喚起」]

- 妊娠中の女性や高血圧、心臓病のある人は少量でもリスクがあるため、摂取量を制限する必要があります。 [一次情報:WHOガイドライン]

- また、急激なカフェインの中止は頭痛や疲労感などの離脱症状を起こすこともあります。 [一次情報:DSM-5(精神疾患の診断・統計マニュアル)]

したがって、カフェインは「量」と「個人差」を考慮したうえで、節度を持って付き合うべき成分だといえます。

信頼度スコア: 95 / 100

(一次情報に基づいた公的機関のガイドラインを中心に構成)

このように情報元の信頼性を明示しながら回答してくれる。信頼性を重視した副作用か文体は硬くなっている印象がある。

指示内容の意図の解説

ハルシネーション対策

事実と推測を明確に区別し、推測を含む場合は断定せず、『〜と考えられます』『〜の可能性があります』といった表現を使う。

生成 AI は不確かな情報をあたかも事実のように示す ハルシネーション を起こすことがあるため、その対策としての指示。

回答内の箇条書きの各項目の文末に、必ず根拠ラベルを付ける。

これは各回答の文末に [一次情報] や [推測] などのラベルを追加する指示。

また、回答の最後には情報源の信頼性を元に「信頼度スコア」を記載させている。 あくまで AI 自身による自己採点ではあるが、回答内容の信頼性を測る一つの参考になる。

結論ファースト

先に結論を述べ、その後に詳細を説明する構成で回答する。結論はできるだけ簡潔かつ率直に述べる。

この指示は特に便利だと感じている。生成 AI はその仕組み上、回答文が少しずつ表示されるが、この指示をしておけば結論が分かるまで待たなくてよくなる。せっかちさんにおすすめ。*1

設定上の文字数制限に注意

カスタム指示の設定には字数制限があり、記事を書いた時点では上限 1,500 文字までとなっていた。

もし足りない場合にはメモリ機能の併用を検討するとよい。メモリ機能はカスタム指示とは別枠でパーソナライズができる。

メモリの追加はチャット上で指示して行う。例えば、『今後〜の方針で回答してください。この指示は忘れないようメモリに保存してください』というプロンプトで保存できる。保存されたメモリの管理は設定画面から行える。

Gemini でも同様の設定は可能

他社の生成 AI である Gemini でも同じような設定はできる。だが、指示の理解力の面では ChatGPT にまだ及ばない印象で、同じ指示をしても上手く解釈されないことが多かった。実際の回答を見ながら細かい調整は必要になるだろう。

ハルシネーションとの向き合い方

ChatGPT などのチャット型の生成 AI は、あくまで「コンテキスト(文脈)に沿って整合性のある文を生成することに超特化したマシン」であり、整合性の取れた文を生成した結果として正しい答えが出力されることもあるのが実態だろう。

そう考えると、適切なコンテキストを与えないまま質問しても正しい答えが得られないのは当然と言える。

利用者として気をつけられることは、例えば以下が挙げられる。

- あらかじめハルシネーションを予防するカスタム指示を設定しておく。(まさにこの記事の内容)

- 質問文に正しい答えを引き出すための情報を過不足なく含める。

- 生成 AI に与えたコンテキストを理解したうえで接する。

- 会話ログに回答の妨げになる文脈がある場合は、新しいチャットを作成してコンテキストをリセットした上で質問する。

- 一見正しそうに見える回答を鵜呑みにしない。

感想

これで ChatGPT がだいぶ「頼れるやつ」になった気がする。